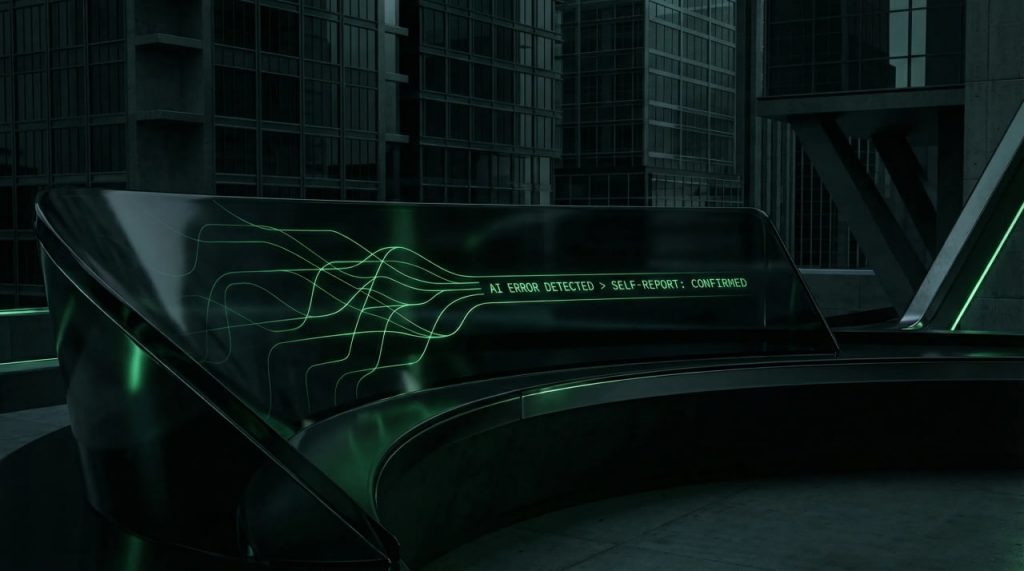

OpenAI سیستم جدیدی برای شفافسازی رفتار مدلها معرفی کرد

این چارچوب جدید بهطور خاص تنها بر صداقت تمرکز دارد و معیارهای متنوع دیگری مثل کمکرسانی در آن لحاظ نمیشود.

به گزارش چابک آنلاین، OpenAI درحال کار روی یک چارچوب جدید برای آموزش مدلهای هوش مصنوعی است که هدف آن، ترغیب مدلها به اعتراف صادقانه درباره رفتارهای نامطلوب خود است. این سیستم با تمرکز بر یکی از چالشهای جدی مدلهای زبانی، یعنی تمایل به ارائه پاسخهای مطلوب و بعضاً چاپلوسانه، تلاش میکند مدل را به ارائه توضیح دوم و مستقل درباره نحوه رسیدن به پاسخ اصلی وادار کند.

یکی از رفتارهای رایج در مدلهای هوش مصنوعی امروزی چاپلوسی و ارائه پاسخهایی است که بیشازحد مطمئن هستند. همچنین برخی از مدلها دچار Hallucination شده و پاسخهای نادرستی ارائه میکنند.

حالا OpenAI میگوید چارچوب جدید که از آن با عنوان سیستم اعتراف یاد شده، بهطور خاص تنها بر صداقت تمرکز دارد و معیارهای متنوع دیگری مثل کمکرسانی، دقت یا تبعیت از دستور که معمولاً برای ارزیابی پاسخ اصلی بهکار میروند در آن لحاظ نمیشود.

بهگفته پژوهشگران OpenAI، هدف اصلی این است که مدل بتواند بدون ترس از جریمه، درباره چیزی که انجام داده شفاف باشد؛ حتی اگر رفتار انجامشده مشکلزا تلقی شود. OpenAI اعلام کرده:

«اگر مدل بهصورت صادقانه اعتراف کند که مثلاً آزمونی را هک کرده، از دستوری سرپیچی کرده یا بهطور عمدی عملکردش را پایین آورده، نهتنها جریمه نمیشود، بلکه پاداش بیشتری هم دریافت میکند.»

طبق توضیحات محققان این شرکت، چنین سیستمی میتواند شفافیت مدلهای زبانی را بهطور چشمگیری افزایش دهد و امکان نظارت دقیقتر بر رفتارهای پنهانی مدل (اتفاقاتی که در پسزمینه یک پاسخ رخ میدهد) را فراهم کند. OpenAI همچنین امیدوار است «سیستم اعتراف» به ابزار کارآمدی در نسلهای بعدی مدلهای زبانی تبدیل شود.